人工智能監督學習(回歸)

回歸是最重要的統計和機器學習工具之一。我們認為機器學習的旅程從回歸開始並不是錯的。它可以被定義為使我們能夠根據數據做出決定的參數化技術,或者換言之,允許通過學習輸入和輸出變量之間的關係來基於數據做出預測。這裡,依賴於輸入變量的輸出變量是連續值的實數。在回歸中,輸入和輸出變量之間的關係很重要,它有助於我們理解輸出變量的值隨輸入變量的變化而變化。回歸常用於預測價格,經濟,變化等。

#data

click.csv

x y

235 591

216 539

148 413

35 310

85 308

204 519

49 325

25 332

173 498

134 392

99 334

117 385

112 387

162 425

272 659

159 400

159 427

59 319

198 522

#tools

import numpy as np

import matplotlib.pyplot as plt

# 讀入學習資料

train = np.loadtxt('click.csv', delimiter=',', skiprows=1)

train_x = train[:,0]

train_y = train[:,1]

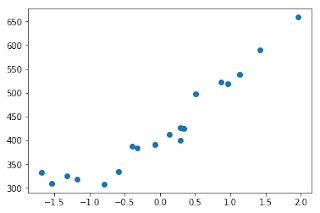

# 圖

#plt.plot(train_x, train_y, 'o')

plt.scatter(train_x, train_y)

plt.show()

# 標準化

mu = train_x.mean()

sigma = train_x.std()

def standardize(x):

return (x - mu) / sigma

train_z = standardize(train_x)

# 圖

#plt.plot(train_z, train_y, 'o')

plt.scatter(train_z, train_y)

plt.show()

# 初始化參數

theta0 = np.random.rand()

theta1 = np.random.rand()

# 預測函數

def f(x):

return theta0 + theta1 * x

# 目標函數

def E(x, y):

return 0.5 * np.sum((y - f(x)) ** 2)

# 學習率

ETA = 1e-3

# 誤差的差分

diff = 1

# 更新次數

count = 0

# 重複學習

error = E(train_z, train_y)

while diff > 1e-2:

# 將更新結果儲存於臨時變數

tmp0 = theta0 - ETA * np.sum((f(train_z) -train_y))

tmp1 = theta1 - ETA * np.sum((f(train_z) -train_y) * train_z)

# 更新參數

theta0 = tmp0

theta1 = tmp1

# 計算與前一項誤差的差分

current_error = E(train_z, train_y)

diff = error - current_error

error = current_error

# 輸出日誌

count += 1

log = '{}次 : theta0 = {:.3f}, theta1 = {:.3f}, 差分 = {:.4f}'

print(log.format(count, theta0, theta1, diff))

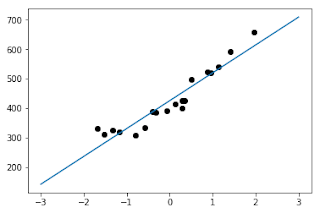

x = np.linspace(-3, 3, 100)

plt.scatter(train_z, train_y, color='black')

plt.plot(x, f(x))

plt.show()

1次 : theta0 = 8.570, theta1 = 2.248, 差分 = 67759.9717

2次 : theta0 = 16.492, theta1 = 4.001, 差分 = 65209.5542

3次 : theta0 = 24.264, theta1 = 5.721, 差分 = 62755.1318

4次 : theta0 = 31.888, theta1 = 7.409, 差分 = 60393.0914

5次 : theta0 = 39.367, theta1 = 9.064, 差分 = 58119.9558

6次 : theta0 = 46.704, theta1 = 10.688, 差分 = 55932.3788

7次 : theta0 = 53.901, theta1 = 12.281, 差分 = 53827.1400

8次 : theta0 = 60.962, theta1 = 13.843, 差分 = 51801.1403

9次 : theta0 = 67.889, theta1 = 15.376, 差分 = 49851.3971

10次 : theta0 = 74.684, theta1 = 16.880, 差分 = 47975.0404

11次 : theta0 = 81.350, theta1 = 18.356, 差分 = 46169.3079

12次 : theta0 = 87.889, theta1 = 19.803, 差分 = 44431.5413

13次 : theta0 = 94.305, theta1 = 21.223, 差分 = 42759.1825

14次 : theta0 = 100.598, theta1 = 22.615, 差分 = 41149.7696

15次 : theta0 = 106.771, theta1 = 23.982, 差分 = 39600.9334

16次 : theta0 = 112.828, theta1 = 25.322, 差分 = 38110.3939

17次 : theta0 = 118.769, theta1 = 26.637, 差分 = 36675.9568

18次 : theta0 = 124.597, theta1 = 27.927, 差分 = 35295.5105

19次 : theta0 = 130.315, theta1 = 29.192, 差分 = 33967.0227

20次 : theta0 = 135.924, theta1 = 30.434, 差分 = 32688.5380

21次 : theta0 = 141.427, theta1 = 31.652, 差分 = 31458.1741

22次 : theta0 = 146.824, theta1 = 32.846, 差分 = 30274.1199

23次 : theta0 = 152.120, theta1 = 34.018, 差分 = 29134.6323

24次 : theta0 = 157.314, theta1 = 35.168, 差分 = 28038.0339

25次 : theta0 = 162.411, theta1 = 36.296, 差分 = 26982.7103

26次 : theta0 = 167.410, theta1 = 37.402, 差分 = 25967.1081

27次 : theta0 = 172.314, theta1 = 38.488, 差分 = 24989.7321

28次 : theta0 = 177.125, theta1 = 39.552, 差分 = 24049.1436

29次 : theta0 = 181.845, theta1 = 40.597, 差分 = 23143.9578

30次 : theta0 = 186.475, theta1 = 41.622, 差分 = 22272.8424

31次 : theta0 = 191.017, theta1 = 42.627, 差分 = 21434.5149

32次 : theta0 = 195.472, theta1 = 43.613, 差分 = 20627.7412

33次 : theta0 = 199.843, theta1 = 44.580, 差分 = 19851.3336

34次 : theta0 = 204.131, theta1 = 45.529, 差分 = 19104.1493

35次 : theta0 = 208.338, theta1 = 46.460, 差分 = 18385.0882

36次 : theta0 = 212.464, theta1 = 47.374, 差分 = 17693.0919

37次 : theta0 = 216.512, theta1 = 48.269, 差分 = 17027.1416

38次 : theta0 = 220.484, theta1 = 49.148, 差分 = 16386.2570

39次 : theta0 = 224.380, theta1 = 50.011, 差分 = 15769.4947

40次 : theta0 = 228.201, theta1 = 50.856, 差分 = 15175.9467

41次 : theta0 = 231.951, theta1 = 51.686, 差分 = 14604.7392

42次 : theta0 = 235.628, theta1 = 52.500, 差分 = 14055.0314

43次 : theta0 = 239.237, theta1 = 53.299, 差分 = 13526.0141

44次 : theta0 = 242.776, theta1 = 54.082, 差分 = 13016.9085

45次 : theta0 = 246.248, theta1 = 54.851, 差分 = 12526.9650

46次 : theta0 = 249.655, theta1 = 55.604, 差分 = 12055.4626

47次 : theta0 = 252.996, theta1 = 56.344, 差分 = 11601.7071

48次 : theta0 = 256.274, theta1 = 57.069, 差分 = 11165.0304

49次 : theta0 = 259.490, theta1 = 57.781, 差分 = 10744.7898

50次 : theta0 = 262.645, theta1 = 58.479, 差分 = 10340.3667

51次 : theta0 = 265.739, theta1 = 59.164, 差分 = 9951.1656

52次 : theta0 = 268.775, theta1 = 59.836, 差分 = 9576.6137

53次 : theta0 = 271.754, theta1 = 60.495, 差分 = 9216.1595

54次 : theta0 = 274.675, theta1 = 61.142, 差分 = 8869.2725

55次 : theta0 = 277.541, theta1 = 61.776, 差分 = 8535.4420

56次 : theta0 = 280.353, theta1 = 62.399, 差分 = 8214.1765

57次 : theta0 = 283.111, theta1 = 63.009, 差分 = 7905.0031

58次 : theta0 = 285.817, theta1 = 63.608, 差分 = 7607.4667

59次 : theta0 = 288.472, theta1 = 64.195, 差分 = 7321.1292

60次 : theta0 = 291.076, theta1 = 64.772, 差分 = 7045.5692

61次 : theta0 = 293.630, theta1 = 65.337, 差分 = 6780.3811

62次 : theta0 = 296.136, theta1 = 65.892, 差分 = 6525.1743

63次 : theta0 = 298.595, theta1 = 66.436, 差分 = 6279.5733

64次 : theta0 = 301.007, theta1 = 66.970, 差分 = 6043.2164

65次 : theta0 = 303.372, theta1 = 67.493, 差分 = 5815.7558

66次 : theta0 = 305.693, theta1 = 68.007, 差分 = 5596.8565

67次 : theta0 = 307.970, theta1 = 68.511, 差分 = 5386.1965

68次 : theta0 = 310.204, theta1 = 69.005, 差分 = 5183.4654

69次 : theta0 = 312.395, theta1 = 69.490, 差分 = 4988.3650

70次 : theta0 = 314.544, theta1 = 69.966, 差分 = 4800.6079

71次 : theta0 = 316.653, theta1 = 70.432, 差分 = 4619.9178

72次 : theta0 = 318.722, theta1 = 70.890, 差分 = 4446.0287

73次 : theta0 = 320.751, theta1 = 71.339, 差分 = 4278.6846

74次 : theta0 = 322.742, theta1 = 71.780, 差分 = 4117.6392

75次 : theta0 = 324.695, theta1 = 72.212, 差分 = 3962.6554

76次 : theta0 = 326.610, theta1 = 72.636, 差分 = 3813.5050

77次 : theta0 = 328.490, theta1 = 73.052, 差分 = 3669.9685

78次 : theta0 = 330.333, theta1 = 73.460, 差分 = 3531.8346

79次 : theta0 = 332.142, theta1 = 73.860, 差分 = 3398.8998

80次 : theta0 = 333.916, theta1 = 74.253, 差分 = 3270.9687

81次 : theta0 = 335.657, theta1 = 74.638, 差分 = 3147.8527

82次 : theta0 = 337.365, theta1 = 75.016, 差分 = 3029.3706

83次 : theta0 = 339.040, theta1 = 75.387, 差分 = 2915.3482

84次 : theta0 = 340.683, theta1 = 75.751, 差分 = 2805.6174

85次 : theta0 = 342.295, theta1 = 76.107, 差分 = 2700.0167

86次 : theta0 = 343.876, theta1 = 76.457, 差分 = 2598.3908

87次 : theta0 = 345.428, theta1 = 76.801, 差分 = 2500.5900

88次 : theta0 = 346.950, theta1 = 77.138, 差分 = 2406.4703

89次 : theta0 = 348.442, theta1 = 77.468, 差分 = 2315.8931

90次 : theta0 = 349.907, theta1 = 77.792, 差分 = 2228.7252

91次 : theta0 = 351.344, theta1 = 78.110, 差分 = 2144.8382

92次 : theta0 = 352.753, theta1 = 78.422, 差分 = 2064.1087

93次 : theta0 = 354.136, theta1 = 78.728, 差分 = 1986.4177

94次 : theta0 = 355.492, theta1 = 79.028, 差分 = 1911.6509

95次 : theta0 = 356.823, theta1 = 79.323, 差分 = 1839.6983

96次 : theta0 = 358.128, theta1 = 79.612, 差分 = 1770.4539

97次 : theta0 = 359.409, theta1 = 79.895, 差分 = 1703.8158

98次 : theta0 = 360.665, theta1 = 80.173, 差分 = 1639.6858

99次 : theta0 = 361.898, theta1 = 80.446, 差分 = 1577.9697

100次 : theta0 = 363.106, theta1 = 80.713, 差分 = 1518.5765

101次 : theta0 = 364.292, theta1 = 80.976, 差分 = 1461.4188

102次 : theta0 = 365.456, theta1 = 81.233, 差分 = 1406.4125

103次 : theta0 = 366.597, theta1 = 81.486, 差分 = 1353.4765

104次 : theta0 = 367.717, theta1 = 81.734, 差分 = 1302.5330

105次 : theta0 = 368.815, theta1 = 81.977, 差分 = 1253.5070

106次 : theta0 = 369.893, theta1 = 82.215, 差分 = 1206.3262

107次 : theta0 = 370.950, theta1 = 82.449, 差分 = 1160.9213

108次 : theta0 = 371.987, theta1 = 82.679, 差分 = 1117.2254

109次 : theta0 = 373.004, theta1 = 82.904, 差分 = 1075.1741

110次 : theta0 = 374.002, theta1 = 83.125, 差分 = 1034.7057

111次 : theta0 = 374.981, theta1 = 83.341, 差分 = 995.7604

112次 : theta0 = 375.941, theta1 = 83.554, 差分 = 958.2809

113次 : theta0 = 376.883, theta1 = 83.763, 差分 = 922.2122

114次 : theta0 = 377.808, theta1 = 83.967, 差分 = 887.5011

115次 : theta0 = 378.714, theta1 = 84.168, 差分 = 854.0964

116次 : theta0 = 379.604, theta1 = 84.365, 差分 = 821.9491

117次 : theta0 = 380.476, theta1 = 84.558, 差分 = 791.0117

118次 : theta0 = 381.332, theta1 = 84.747, 差分 = 761.2388

119次 : theta0 = 382.172, theta1 = 84.933, 差分 = 732.5866

120次 : theta0 = 382.996, theta1 = 85.115, 差分 = 705.0128

121次 : theta0 = 383.804, theta1 = 85.294, 差分 = 678.4768

122次 : theta0 = 384.596, theta1 = 85.470, 差分 = 652.9396

123次 : theta0 = 385.374, theta1 = 85.642, 差分 = 628.3636

124次 : theta0 = 386.137, theta1 = 85.811, 差分 = 604.7126

125次 : theta0 = 386.885, theta1 = 85.976, 差分 = 581.9518

126次 : theta0 = 387.620, theta1 = 86.139, 差分 = 560.0478

127次 : theta0 = 388.340, theta1 = 86.298, 差分 = 538.9681

128次 : theta0 = 389.046, theta1 = 86.454, 差分 = 518.6819

129次 : theta0 = 389.739, theta1 = 86.608, 差分 = 499.1592

130次 : theta0 = 390.419, theta1 = 86.758, 差分 = 480.3714

131次 : theta0 = 391.086, theta1 = 86.906, 差分 = 462.2907

132次 : theta0 = 391.741, theta1 = 87.051, 差分 = 444.8905

133次 : theta0 = 392.383, theta1 = 87.193, 差分 = 428.1453

134次 : theta0 = 393.012, theta1 = 87.332, 差分 = 412.0303

135次 : theta0 = 393.630, theta1 = 87.469, 差分 = 396.5219

136次 : theta0 = 394.236, theta1 = 87.603, 差分 = 381.5972

137次 : theta0 = 394.831, theta1 = 87.735, 差分 = 367.2343

138次 : theta0 = 395.414, theta1 = 87.864, 差分 = 353.4120

139次 : theta0 = 395.986, theta1 = 87.990, 差分 = 340.1099

140次 : theta0 = 396.547, theta1 = 88.115, 差分 = 327.3085

141次 : theta0 = 397.098, theta1 = 88.236, 差分 = 314.9889

142次 : theta0 = 397.638, theta1 = 88.356, 差分 = 303.1331

143次 : theta0 = 398.168, theta1 = 88.473, 差分 = 291.7234

144次 : theta0 = 398.688, theta1 = 88.588, 差分 = 280.7433

145次 : theta0 = 399.198, theta1 = 88.701, 差分 = 270.1764

146次 : theta0 = 399.698, theta1 = 88.812, 差分 = 260.0072

147次 : theta0 = 400.189, theta1 = 88.920, 差分 = 250.2208

148次 : theta0 = 400.670, theta1 = 89.027, 差分 = 240.8027

149次 : theta0 = 401.142, theta1 = 89.132, 差分 = 231.7391

150次 : theta0 = 401.606, theta1 = 89.234, 差分 = 223.0167

151次 : theta0 = 402.060, theta1 = 89.335, 差分 = 214.6226

152次 : theta0 = 402.506, theta1 = 89.433, 差分 = 206.5444

153次 : theta0 = 402.943, theta1 = 89.530, 差分 = 198.7703

154次 : theta0 = 403.372, theta1 = 89.625, 差分 = 191.2888

155次 : theta0 = 403.793, theta1 = 89.718, 差分 = 184.0889

156次 : theta0 = 404.206, theta1 = 89.810, 差分 = 177.1599

157次 : theta0 = 404.611, theta1 = 89.899, 差分 = 170.4918

158次 : theta0 = 405.009, theta1 = 89.987, 差分 = 164.0747

159次 : theta0 = 405.399, theta1 = 90.074, 差分 = 157.8991

160次 : theta0 = 405.781, theta1 = 90.158, 差分 = 151.9559

161次 : theta0 = 406.156, theta1 = 90.241, 差分 = 146.2364

162次 : theta0 = 406.524, theta1 = 90.323, 差分 = 140.7322

163次 : theta0 = 406.885, theta1 = 90.403, 差分 = 135.4352

164次 : theta0 = 407.239, theta1 = 90.481, 差分 = 130.3376

165次 : theta0 = 407.587, theta1 = 90.558, 差分 = 125.4318

166次 : theta0 = 407.928, theta1 = 90.633, 差分 = 120.7107

167次 : theta0 = 408.262, theta1 = 90.707, 差分 = 116.1672

168次 : theta0 = 408.590, theta1 = 90.780, 差分 = 111.7948

169次 : theta0 = 408.912, theta1 = 90.851, 差分 = 107.5870

170次 : theta0 = 409.228, theta1 = 90.921, 差分 = 103.5375

171次 : theta0 = 409.537, theta1 = 90.989, 差分 = 99.6405

172次 : theta0 = 409.841, theta1 = 91.057, 差分 = 95.8901

173次 : theta0 = 410.139, theta1 = 91.123, 差分 = 92.2809

174次 : theta0 = 410.431, theta1 = 91.187, 差分 = 88.8075

175次 : theta0 = 410.718, theta1 = 91.251, 差分 = 85.4649

176次 : theta0 = 411.000, theta1 = 91.313, 差分 = 82.2481

177次 : theta0 = 411.276, theta1 = 91.374, 差分 = 79.1524

178次 : theta0 = 411.546, theta1 = 91.434, 差分 = 76.1731

179次 : theta0 = 411.812, theta1 = 91.493, 差分 = 73.3061

180次 : theta0 = 412.073, theta1 = 91.551, 差分 = 70.5469

181次 : theta0 = 412.328, theta1 = 91.607, 差分 = 67.8916

182次 : theta0 = 412.579, theta1 = 91.663, 差分 = 65.3362

183次 : theta0 = 412.825, theta1 = 91.717, 差分 = 62.8770

184次 : theta0 = 413.066, theta1 = 91.770, 差分 = 60.5104

185次 : theta0 = 413.303, theta1 = 91.823, 差分 = 58.2328

186次 : theta0 = 413.535, theta1 = 91.874, 差分 = 56.0410

187次 : theta0 = 413.763, theta1 = 91.925, 差分 = 53.9317

188次 : theta0 = 413.987, theta1 = 91.974, 差分 = 51.9017

189次 : theta0 = 414.206, theta1 = 92.023, 差分 = 49.9482

190次 : theta0 = 414.421, theta1 = 92.070, 差分 = 48.0682

191次 : theta0 = 414.632, theta1 = 92.117, 差分 = 46.2590

192次 : theta0 = 414.839, theta1 = 92.163, 差分 = 44.5178

193次 : theta0 = 415.042, theta1 = 92.208, 差分 = 42.8422

194次 : theta0 = 415.241, theta1 = 92.252, 差分 = 41.2297

195次 : theta0 = 415.437, theta1 = 92.295, 差分 = 39.6778

196次 : theta0 = 415.628, theta1 = 92.338, 差分 = 38.1844

197次 : theta0 = 415.816, theta1 = 92.379, 差分 = 36.7472

198次 : theta0 = 416.001, theta1 = 92.420, 差分 = 35.3641

199次 : theta0 = 416.182, theta1 = 92.460, 差分 = 34.0330

200次 : theta0 = 416.359, theta1 = 92.499, 差分 = 32.7520

201次 : theta0 = 416.534, theta1 = 92.538, 差分 = 31.5193

202次 : theta0 = 416.704, theta1 = 92.576, 差分 = 30.3329

203次 : theta0 = 416.872, theta1 = 92.613, 差分 = 29.1912

204次 : theta0 = 417.036, theta1 = 92.649, 差分 = 28.0925

205次 : theta0 = 417.198, theta1 = 92.685, 差分 = 27.0351

206次 : theta0 = 417.356, theta1 = 92.720, 差分 = 26.0175

207次 : theta0 = 417.511, theta1 = 92.754, 差分 = 25.0383

208次 : theta0 = 417.664, theta1 = 92.788, 差分 = 24.0959

209次 : theta0 = 417.813, theta1 = 92.821, 差分 = 23.1889

210次 : theta0 = 417.959, theta1 = 92.853, 差分 = 22.3161

211次 : theta0 = 418.103, theta1 = 92.885, 差分 = 21.4761

212次 : theta0 = 418.244, theta1 = 92.916, 差分 = 20.6678

213次 : theta0 = 418.383, theta1 = 92.947, 差分 = 19.8899

214次 : theta0 = 418.518, theta1 = 92.977, 差分 = 19.1413

215次 : theta0 = 418.652, theta1 = 93.007, 差分 = 18.4208

216次 : theta0 = 418.782, theta1 = 93.036, 差分 = 17.7275

217次 : theta0 = 418.910, theta1 = 93.064, 差分 = 17.0602

218次 : theta0 = 419.036, theta1 = 93.092, 差分 = 16.4181

219次 : theta0 = 419.159, theta1 = 93.119, 差分 = 15.8001

220次 : theta0 = 419.280, theta1 = 93.146, 差分 = 15.2054

221次 : theta0 = 419.399, theta1 = 93.172, 差分 = 14.6331

222次 : theta0 = 419.515, theta1 = 93.198, 差分 = 14.0823

223次 : theta0 = 419.630, theta1 = 93.223, 差分 = 13.5523

224次 : theta0 = 419.742, theta1 = 93.248, 差分 = 13.0422

225次 : theta0 = 419.852, theta1 = 93.272, 差分 = 12.5513

226次 : theta0 = 419.959, theta1 = 93.296, 差分 = 12.0789

227次 : theta0 = 420.065, theta1 = 93.319, 差分 = 11.6242

228次 : theta0 = 420.169, theta1 = 93.342, 差分 = 11.1867

229次 : theta0 = 420.271, theta1 = 93.365, 差分 = 10.7657

230次 : theta0 = 420.371, theta1 = 93.387, 差分 = 10.3604

231次 : theta0 = 420.469, theta1 = 93.409, 差分 = 9.9705

232次 : theta0 = 420.565, theta1 = 93.430, 差分 = 9.5952

233次 : theta0 = 420.659, theta1 = 93.451, 差分 = 9.2341

234次 : theta0 = 420.751, theta1 = 93.471, 差分 = 8.8865

235次 : theta0 = 420.842, theta1 = 93.491, 差分 = 8.5520

236次 : theta0 = 420.931, theta1 = 93.511, 差分 = 8.2301

237次 : theta0 = 421.018, theta1 = 93.530, 差分 = 7.9204

238次 : theta0 = 421.104, theta1 = 93.549, 差分 = 7.6222

239次 : theta0 = 421.188, theta1 = 93.568, 差分 = 7.3353

240次 : theta0 = 421.270, theta1 = 93.586, 差分 = 7.0593

241次 : theta0 = 421.351, theta1 = 93.604, 差分 = 6.7935

242次 : theta0 = 421.431, theta1 = 93.622, 差分 = 6.5378

243次 : theta0 = 421.508, theta1 = 93.639, 差分 = 6.2918

244次 : theta0 = 421.585, theta1 = 93.656, 差分 = 6.0550

245次 : theta0 = 421.660, theta1 = 93.672, 差分 = 5.8271

246次 : theta0 = 421.733, theta1 = 93.689, 差分 = 5.6077

247次 : theta0 = 421.805, theta1 = 93.705, 差分 = 5.3967

248次 : theta0 = 421.876, theta1 = 93.720, 差分 = 5.1935

249次 : theta0 = 421.945, theta1 = 93.736, 差分 = 4.9981

250次 : theta0 = 422.013, theta1 = 93.751, 差分 = 4.8099

251次 : theta0 = 422.080, theta1 = 93.765, 差分 = 4.6289

252次 : theta0 = 422.146, theta1 = 93.780, 差分 = 4.4547

253次 : theta0 = 422.210, theta1 = 93.794, 差分 = 4.2870

254次 : theta0 = 422.273, theta1 = 93.808, 差分 = 4.1256

255次 : theta0 = 422.335, theta1 = 93.822, 差分 = 3.9704

256次 : theta0 = 422.395, theta1 = 93.835, 差分 = 3.8209

257次 : theta0 = 422.455, theta1 = 93.848, 差分 = 3.6771

258次 : theta0 = 422.513, theta1 = 93.861, 差分 = 3.5387

259次 : theta0 = 422.570, theta1 = 93.874, 差分 = 3.4055

260次 : theta0 = 422.627, theta1 = 93.886, 差分 = 3.2773

261次 : theta0 = 422.682, theta1 = 93.899, 差分 = 3.1540

262次 : theta0 = 422.736, theta1 = 93.911, 差分 = 3.0353

263次 : theta0 = 422.789, theta1 = 93.922, 差分 = 2.9210

264次 : theta0 = 422.841, theta1 = 93.934, 差分 = 2.8111

265次 : theta0 = 422.892, theta1 = 93.945, 差分 = 2.7053

266次 : theta0 = 422.942, theta1 = 93.956, 差分 = 2.6034

267次 : theta0 = 422.991, theta1 = 93.967, 差分 = 2.5054

268次 : theta0 = 423.039, theta1 = 93.978, 差分 = 2.4111

269次 : theta0 = 423.086, theta1 = 93.988, 差分 = 2.3204

270次 : theta0 = 423.133, theta1 = 93.998, 差分 = 2.2331

271次 : theta0 = 423.178, theta1 = 94.008, 差分 = 2.1490

272次 : theta0 = 423.223, theta1 = 94.018, 差分 = 2.0681

273次 : theta0 = 423.267, theta1 = 94.028, 差分 = 1.9903

274次 : theta0 = 423.309, theta1 = 94.038, 差分 = 1.9154

275次 : theta0 = 423.352, theta1 = 94.047, 差分 = 1.8433

276次 : theta0 = 423.393, theta1 = 94.056, 差分 = 1.7739

277次 : theta0 = 423.433, theta1 = 94.065, 差分 = 1.7071

278次 : theta0 = 423.473, theta1 = 94.074, 差分 = 1.6429

279次 : theta0 = 423.512, theta1 = 94.082, 差分 = 1.5810

280次 : theta0 = 423.551, theta1 = 94.091, 差分 = 1.5215

281次 : theta0 = 423.588, theta1 = 94.099, 差分 = 1.4643

282次 : theta0 = 423.625, theta1 = 94.107, 差分 = 1.4091

283次 : theta0 = 423.661, theta1 = 94.115, 差分 = 1.3561

284次 : theta0 = 423.696, theta1 = 94.123, 差分 = 1.3051

285次 : theta0 = 423.731, theta1 = 94.131, 差分 = 1.2559

286次 : theta0 = 423.765, theta1 = 94.138, 差分 = 1.2087

287次 : theta0 = 423.799, theta1 = 94.146, 差分 = 1.1632

288次 : theta0 = 423.832, theta1 = 94.153, 差分 = 1.1194

289次 : theta0 = 423.864, theta1 = 94.160, 差分 = 1.0773

290次 : theta0 = 423.895, theta1 = 94.167, 差分 = 1.0367

291次 : theta0 = 423.926, theta1 = 94.174, 差分 = 0.9977

292次 : theta0 = 423.957, theta1 = 94.181, 差分 = 0.9601

293次 : theta0 = 423.987, theta1 = 94.187, 差分 = 0.9240

294次 : theta0 = 424.016, theta1 = 94.194, 差分 = 0.8892

295次 : theta0 = 424.045, theta1 = 94.200, 差分 = 0.8558

296次 : theta0 = 424.073, theta1 = 94.206, 差分 = 0.8235

297次 : theta0 = 424.100, theta1 = 94.213, 差分 = 0.7925

298次 : theta0 = 424.127, theta1 = 94.219, 差分 = 0.7627

299次 : theta0 = 424.154, theta1 = 94.224, 差分 = 0.7340

300次 : theta0 = 424.180, theta1 = 94.230, 差分 = 0.7064

301次 : theta0 = 424.206, theta1 = 94.236, 差分 = 0.6798

302次 : theta0 = 424.231, theta1 = 94.241, 差分 = 0.6542

303次 : theta0 = 424.255, theta1 = 94.247, 差分 = 0.6296

304次 : theta0 = 424.280, theta1 = 94.252, 差分 = 0.6059

305次 : theta0 = 424.303, theta1 = 94.257, 差分 = 0.5831

306次 : theta0 = 424.326, theta1 = 94.263, 差分 = 0.5611

307次 : theta0 = 424.349, theta1 = 94.268, 差分 = 0.5400

308次 : theta0 = 424.372, theta1 = 94.273, 差分 = 0.5197

309次 : theta0 = 424.394, theta1 = 94.277, 差分 = 0.5001

310次 : theta0 = 424.415, theta1 = 94.282, 差分 = 0.4813

311次 : theta0 = 424.436, theta1 = 94.287, 差分 = 0.4632

312次 : theta0 = 424.457, theta1 = 94.291, 差分 = 0.4458

313次 : theta0 = 424.477, theta1 = 94.296, 差分 = 0.4290

314次 : theta0 = 424.497, theta1 = 94.300, 差分 = 0.4128

315次 : theta0 = 424.517, theta1 = 94.305, 差分 = 0.3973

316次 : theta0 = 424.536, theta1 = 94.309, 差分 = 0.3823

317次 : theta0 = 424.555, theta1 = 94.313, 差分 = 0.3679

318次 : theta0 = 424.573, theta1 = 94.317, 差分 = 0.3541

319次 : theta0 = 424.591, theta1 = 94.321, 差分 = 0.3408

320次 : theta0 = 424.609, theta1 = 94.325, 差分 = 0.3279

321次 : theta0 = 424.626, theta1 = 94.329, 差分 = 0.3156

322次 : theta0 = 424.644, theta1 = 94.333, 差分 = 0.3037

323次 : theta0 = 424.660, theta1 = 94.336, 差分 = 0.2923

324次 : theta0 = 424.677, theta1 = 94.340, 差分 = 0.2813

325次 : theta0 = 424.693, theta1 = 94.344, 差分 = 0.2707

326次 : theta0 = 424.709, theta1 = 94.347, 差分 = 0.2605

327次 : theta0 = 424.724, theta1 = 94.351, 差分 = 0.2507

328次 : theta0 = 424.740, theta1 = 94.354, 差分 = 0.2413

329次 : theta0 = 424.754, theta1 = 94.357, 差分 = 0.2322

330次 : theta0 = 424.769, theta1 = 94.361, 差分 = 0.2234

331次 : theta0 = 424.784, theta1 = 94.364, 差分 = 0.2150

332次 : theta0 = 424.798, theta1 = 94.367, 差分 = 0.2069

333次 : theta0 = 424.811, theta1 = 94.370, 差分 = 0.1992

334次 : theta0 = 424.825, theta1 = 94.373, 差分 = 0.1917

335次 : theta0 = 424.838, theta1 = 94.376, 差分 = 0.1844

336次 : theta0 = 424.851, theta1 = 94.379, 差分 = 0.1775

337次 : theta0 = 424.864, theta1 = 94.382, 差分 = 0.1708

338次 : theta0 = 424.877, theta1 = 94.384, 差分 = 0.1644

339次 : theta0 = 424.889, theta1 = 94.387, 差分 = 0.1582

340次 : theta0 = 424.901, theta1 = 94.390, 差分 = 0.1523

341次 : theta0 = 424.913, theta1 = 94.392, 差分 = 0.1465

342次 : theta0 = 424.925, theta1 = 94.395, 差分 = 0.1410

343次 : theta0 = 424.936, theta1 = 94.398, 差分 = 0.1357

344次 : theta0 = 424.947, theta1 = 94.400, 差分 = 0.1306

345次 : theta0 = 424.958, theta1 = 94.402, 差分 = 0.1257

346次 : theta0 = 424.969, theta1 = 94.405, 差分 = 0.1209

347次 : theta0 = 424.980, theta1 = 94.407, 差分 = 0.1164

348次 : theta0 = 424.990, theta1 = 94.409, 差分 = 0.1120

349次 : theta0 = 425.000, theta1 = 94.412, 差分 = 0.1078

350次 : theta0 = 425.010, theta1 = 94.414, 差分 = 0.1037

351次 : theta0 = 425.020, theta1 = 94.416, 差分 = 0.0998

352次 : theta0 = 425.030, theta1 = 94.418, 差分 = 0.0961

353次 : theta0 = 425.039, theta1 = 94.420, 差分 = 0.0925

354次 : theta0 = 425.049, theta1 = 94.422, 差分 = 0.0890

355次 : theta0 = 425.058, theta1 = 94.424, 差分 = 0.0856

356次 : theta0 = 425.066, theta1 = 94.426, 差分 = 0.0824

357次 : theta0 = 425.075, theta1 = 94.428, 差分 = 0.0793

358次 : theta0 = 425.084, theta1 = 94.430, 差分 = 0.0763

359次 : theta0 = 425.092, theta1 = 94.432, 差分 = 0.0734

360次 : theta0 = 425.100, theta1 = 94.434, 差分 = 0.0707

361次 : theta0 = 425.109, theta1 = 94.436, 差分 = 0.0680

362次 : theta0 = 425.116, theta1 = 94.437, 差分 = 0.0655

363次 : theta0 = 425.124, theta1 = 94.439, 差分 = 0.0630

364次 : theta0 = 425.132, theta1 = 94.441, 差分 = 0.0606

365次 : theta0 = 425.139, theta1 = 94.443, 差分 = 0.0583

366次 : theta0 = 425.147, theta1 = 94.444, 差分 = 0.0561

367次 : theta0 = 425.154, theta1 = 94.446, 差分 = 0.0540

368次 : theta0 = 425.161, theta1 = 94.447, 差分 = 0.0520

369次 : theta0 = 425.168, theta1 = 94.449, 差分 = 0.0500

370次 : theta0 = 425.175, theta1 = 94.450, 差分 = 0.0482

371次 : theta0 = 425.181, theta1 = 94.452, 差分 = 0.0463

372次 : theta0 = 425.188, theta1 = 94.453, 差分 = 0.0446

373次 : theta0 = 425.194, theta1 = 94.455, 差分 = 0.0429

374次 : theta0 = 425.201, theta1 = 94.456, 差分 = 0.0413

375次 : theta0 = 425.207, theta1 = 94.457, 差分 = 0.0398

376次 : theta0 = 425.213, theta1 = 94.459, 差分 = 0.0383

377次 : theta0 = 425.219, theta1 = 94.460, 差分 = 0.0368

378次 : theta0 = 425.225, theta1 = 94.461, 差分 = 0.0354

379次 : theta0 = 425.231, theta1 = 94.463, 差分 = 0.0341

380次 : theta0 = 425.236, theta1 = 94.464, 差分 = 0.0328

381次 : theta0 = 425.242, theta1 = 94.465, 差分 = 0.0316

382次 : theta0 = 425.247, theta1 = 94.466, 差分 = 0.0304

383次 : theta0 = 425.252, theta1 = 94.468, 差分 = 0.0292

384次 : theta0 = 425.258, theta1 = 94.469, 差分 = 0.0281

385次 : theta0 = 425.263, theta1 = 94.470, 差分 = 0.0271

386次 : theta0 = 425.268, theta1 = 94.471, 差分 = 0.0261

387次 : theta0 = 425.273, theta1 = 94.472, 差分 = 0.0251

388次 : theta0 = 425.277, theta1 = 94.473, 差分 = 0.0241

389次 : theta0 = 425.282, theta1 = 94.474, 差分 = 0.0232

390次 : theta0 = 425.287, theta1 = 94.475, 差分 = 0.0224

391次 : theta0 = 425.291, theta1 = 94.476, 差分 = 0.0215

392次 : theta0 = 425.296, theta1 = 94.477, 差分 = 0.0207

393次 : theta0 = 425.300, theta1 = 94.478, 差分 = 0.0199

394次 : theta0 = 425.304, theta1 = 94.479, 差分 = 0.0192

395次 : theta0 = 425.309, theta1 = 94.480, 差分 = 0.0185

396次 : theta0 = 425.313, theta1 = 94.481, 差分 = 0.0178

397次 : theta0 = 425.317, theta1 = 94.482, 差分 = 0.0171

398次 : theta0 = 425.321, theta1 = 94.483, 差分 = 0.0164

399次 : theta0 = 425.325, theta1 = 94.484, 差分 = 0.0158

400次 : theta0 = 425.329, theta1 = 94.484, 差分 = 0.0152

401次 : theta0 = 425.332, theta1 = 94.485, 差分 = 0.0147

402次 : theta0 = 425.336, theta1 = 94.486, 差分 = 0.0141

403次 : theta0 = 425.340, theta1 = 94.487, 差分 = 0.0136

404次 : theta0 = 425.343, theta1 = 94.488, 差分 = 0.0131

405次 : theta0 = 425.347, theta1 = 94.488, 差分 = 0.0126

406次 : theta0 = 425.350, theta1 = 94.489, 差分 = 0.0121

407次 : theta0 = 425.353, theta1 = 94.490, 差分 = 0.0116

408次 : theta0 = 425.357, theta1 = 94.491, 差分 = 0.0112

409次 : theta0 = 425.360, theta1 = 94.491, 差分 = 0.0108

410次 : theta0 = 425.363, theta1 = 94.492, 差分 = 0.0104

411次 : theta0 = 425.366, theta1 = 94.493, 差分 = 0.0100